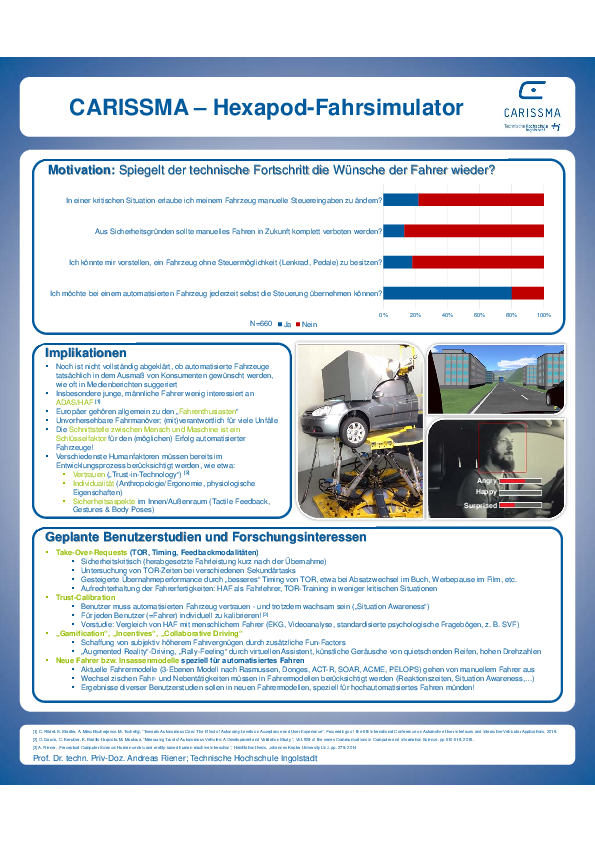

Fahrzeugsteuerung mit dem eigenen Smartphone oder Tablet? Ein automatisiertes Fahrzeug, das den Fahrer beobachtet und sein Verhalten an wechselnde Gegebenheiten anpasst? Ein Augmented-Reality „Heads-up-Display“ welches relevante Informationen direkt an Objekten im Außenraum platziert? Im CARISSMA-Fahrsimulationslabor ist nichts unmöglich. Hier wird bereits heute demonstriert, wie Menschen in naher und ferner Zukunft mit Fahrzeugen in verschiedenen Automatisierungsstufen interagieren könn(t)en.

Das Spektrum reicht dabei von Grundlagenforschung (z.B. zum Thema „Motion Sickness“/Reisekrankheit), über eine Evaluierung von Fahrverhalten und Nutzerwünschen bis hin zur Implementierung und Erprobung von Prototypen für zukünftige Interaktionskonzepte bzw. Mensch-Maschine Schnittstellen (engl. „Human-Machine-Interface“, HMI) im Fahrzeug – immer mit dem Ziel, sowohl die Sicherheit als auch das Benutzererlebnis („User Experience“) zu erhöhen. Dies erfolgt unter Einbeziehung modernster Messinstrumente und -verfahren, wie etwa Eye Tracking, EKG oder EEG.

Die Forschungsaktivitäten im Fahrsimulator-Labor orientieren sich dabei an der Forschungsprogrammatik des Forschungs- und Testzentrums CARISSMA.

Fahrsimulator (Hexapode)

Ziele und Ideen

Für Probandenstudien stehen eine Reihe an Simulatoren zur Verfügung mit welchen, je nach Bedarf, Studien in virtueller Realität oder im statischen Kontext durchgeführt werden können. Herzstück des Labors ist der dynamische Fahrsimulator (Hexapodenprüfstand). Dieser besteht aus einem realen Halbfahrzeug (VW Golf), das auf einer hydraulischen Bewegungsplattform montiert ist. Die Fenster der in sechs Freiheitsgraden beweglichen Fahrerkabine werden mit insgesamt vier Projektoren sowie einem zusätzlichen Monitor für den Rückspiegel bespielt, um Probanden ein möglichst realistisches Fahrerlebnis zu bieten. Zusätzlich wurde der Innenraum des Fahrzeuges so modifiziert, dass eine Reihe von Tablet-Computern das Instrumenten-Cluster, die Mittelkonsole, sowie den Beifahrerbereich abdecken.

Das CARISSMA Forschungsteam „Human Computer Interaction Group“ (HCIG) verfügt über weitreichende Kompetenzen in den Bereichen automatisiertes Fahren, „Human Factors“, Augmented/Virtual Reality, Prototyping von Mensch-Maschine Schnittstellen, Usability-Forschung und User Experience Design – aber auch in Statistik und Psychologie, und konnte mit ihren interdisziplinären Forschungsarbeiten bereits mehrere Auszeichnungen auf internationalen Konferenzen gewinnen.

Ausstattung

Modifizierter Abschnitt eines VW Golf, Hydraulikplattform, Videoüberwachungs- und Kommunikationsanlage, hochsensibles Lenksystem mit Force-Feedback, moderne Computer zur realistischen Simulation und Visualisierung von manuellen und automatisierten Fahrszenarien. An Software kommen IPG CarMaker und Vires VTD zum Einsatz.

Darüber hinaus stehen mehrere low-fidelity Fahrsimulatoren (Sitzkiste mit Logitech G27 Lenkrad, drei 55“-Monitore, etc.) zur einfachen, kostengünstigen Untersuchung – insbesondere für studentische Projekte und Vorstudien – zur Verfügung.

Mehrere Tablets unterschiedlicher Größe/Ausstattung (u.a. Google-Pixel C 10“, NVIDIA Shield 8“), welche für unterschiedliche Einsatzszenarien im modifizierbaren Innenraum der Fahrerkabine angebracht werden können. Darüber hinaus ist das Labor mit diversen LeapMotion Gesten- und RealSense Tiefen-Kameras, sowie Myo Armbänder, Arduino-Kits zum Prototyping, uvm. ausgestattet. Ein 3D-Drucker (Ultimaker 2+) steht zu raschen Realisierung von Hardware-Prototypen zur Verfügung.

Das VR/AR-Equipment umfasst mehrere Virtual Reality-Brillen (HTC Vive, Oculus Rift) sowie Augmented Reality-Geräte (Microsoft HoloLens, Cardboards) inklusive Bewegungstracking und einem leistungsstarken Notebook. Hiermit können sowohl komplexe Umgebungen für „Vulnerable Road Users“ (z.B. Fußgängersimulator) simuliert, als auch AR/VR-Anwendungen für Fahrer/Passagiere zukünftiger Fahrzeuggenerationen realisiert werden.

Mit Hilfe modernster physiologischer Messtechnik bleibt kein Detail verborgen. Professionelles EKG/EEG/GSR-Equipment (gtec, Empatica) sowie Eye-Tracking-Brillen (Tobii Glasses Pro2+, PupilLabs) stehen im Labor ebenso zur Verfügung wie unterschiedliche RGB- und Tiefenbildkameras (Intel Realsense, GoPro) um damit kleinste Reaktionen der Probanden zu erkennen und mittels Software-Frameworks (Affectiva Emotion API) zu klassifizieren.

Mit Hilfe eines in-house entwickelten Software-Frameworks können sämtliche Geräte und Software-Komponenten synchronisiert angesteuert, Daten zwischen ihnen dynamisch ausgetauscht, und neue Komponenten einfach eingebunden werden. Das garantiert einen reproduzierbaren Versuchsablauf und schnell realisierbare dynamische Prototypen.

Anwendungsbeispiele

- Probandenstudien zu sicherheitskritischen Faktoren in unterschiedlichen Automatisierungsstufen („Driver Take Over“, „Driver Monitoring“, „Automation Trust“, etc.) sowie zur Akzeptanzuntersuchung neuer ADAS-Systeme (AEB, etc.)

- Evaluierung von alternativen, „shared-control“ Interfaces für zukünftige Fahrzeuggenerationen

- Fahrerzustandsüberwachung (Müdigkeitserkennung, Attentive User Interfaces) für verbesserte Fahrer-Fahrzeug Kommunikation und Interaktion

- Prototyping zukünftiger Fahrzeug-Innenräume in automatisierten Fahrzeugen („Mobile Office“)

- Implementierung und Evaluierung von Anwendungen für Vollformat-AR- Displays in Fahrzeugen (sog. „Windshield Displays“, WSDs

- Internationale Studien zur Verkehrssicherheit

- Fahrerschnittstelle zur Integration in HiL- und Gesamtfahrzeug-Prüfstände im modularen Sicherheits-Laborfahrzeug (CARISSMA-Prüfstandsverbund)

Laborleitung und Team

Prof. Dr. techn. Priv.-Doz. Andreas Riener

Tel.: +49 841 9348-2833

Raum: B210

E-Mail: Andreas.Riener@thi.de

Thomas Hempen, M.Sc.

Tel.: +49 841 9348-6421

Raum: P303

Fax: +49 841 9348-996421

E-Mail: Thomas.Hempen@carissma.eu

Technologiefelder

Testsysteme